Inhaltsverzeichnis

1 Ziel der einfachen linearen Regression

Eine einfache lineare Regressionsanalyse hat das Ziel eine abhängige Variable (y) mittels einer unabhängigen Variablen (x) zu erklären. Es ist ein quantitatives Verfahren, das zur Prognose einer Variable dient.

Die einfache lineare Regression testet auf Zusammenhänge zwischen x und y. Für mehr als eine x-Variable wird die multiple lineare Regression verwendet. Solltet ihr Excel verwenden, schaut euch diesen Artikel an. Im Vorfeld der Regressionsanalyse kann zudem eine Filterung vorgenommen werden, um nur einen gewissen Teil der Stichprobe zu untersuchen, bei dem man am ehesten einen Effekt erwartet.

2 Voraussetzungen der einfachen linearen Regression

Die wichtigsten Voraussetzungen sind, und werden in jeweils verlinkten Artikeln separat gezeigt:

- linearer Zusammenhang zwischen x und y-Variable

- metrisch skalierte y-Variable – bei binär codierter y-Variable ist eine binär logistische Regression zu rechnen

- normalverteilte Fehlerterme

- Homoskedastizität – homogen streuende Varianzen des Fehlerterms (grafische Prüfung oder analytische Prüfung)

- keine Autokorrelation – Unabhängigkeit der Fehlerterme bei sortierten Daten (Vorsicht bei Durbin-Watson-Test!)

- Optional: fehlende Werte definieren, fehlende Werte identifizieren und fehlende Werte ersetzen

- Kontrolle für einflussreiche Fälle bzw. “Ausreißer”

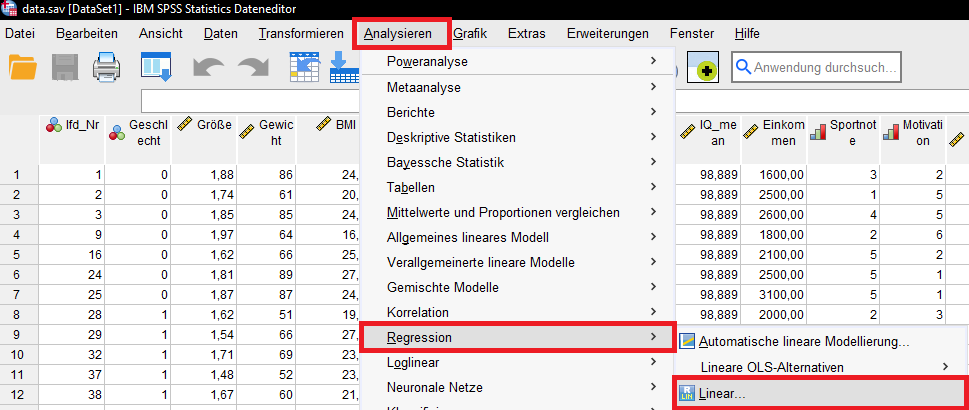

3 Durchführung der einfachen linearen Regression in SPSS

Über das Menü in SPSS: Analysieren – Regression – Linear

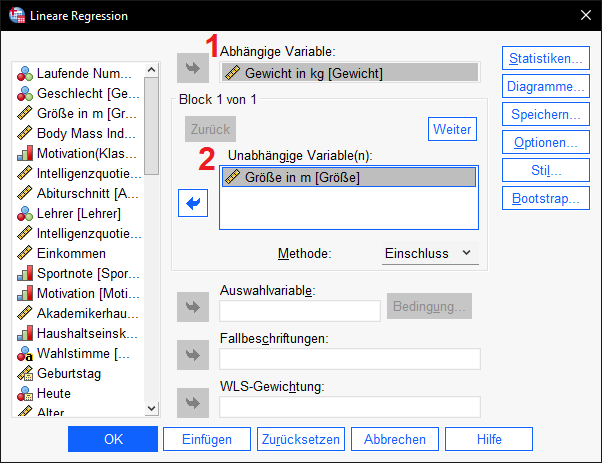

Das von mir gewählte Beispiel versucht das Gewicht von Personen durch deren Größe zu erklären.

Die abhängige (y-)Variable (im Bild: 1) ist also das Gewicht und die unabhängige (x-)Variable (im Bild: 2) die Größe.

4 Interpretation der Ergebnisse der einfachen linearen Regression in SPSS

Sofern die in Gliederungspunkt 2 genannten Voraussetzungen erfüllt sind, sind drei Dinge besonders wichtig.

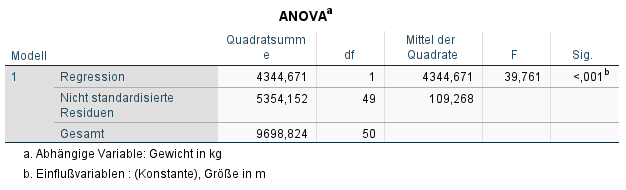

4.1 ANOVA-Tabelle – Signifikanz des F-Tests

Die ANOVA-Tabelle sollte einen signifikanten p-Wert (typischerweise <0.05) für den F-Test bei “Sig.” ausweisen – ist dies gegeben, leistet das Regressionsmodell einen Erklärungsbeitrag. Die Nullhypothese lautet beim F-Test: kein signifikanter Erklärungsbeitrag durch das Modell. Sie wird bei p < 0.05 verworfen. Im Beispiel ist die Signifikanz mit < 0.001 definitiv klein genug und damit leistet das spezifizierte Regressionsmodell einen (signifikanten) Erklärungsbeitrag.

Hinweis: Mit Doppelklick auf den p-Wert erhält man den exakten Wert (7.8953E-8). Das ist die wissenschaftliche Schreibweise und E-8 bedeutet, dass das Komma um 8 Stellen nach links versetzt wird.

Folglich: p = 7.8953E-8 = 0.000000078953, also abgekürzt p < .001.

![]()

![]()

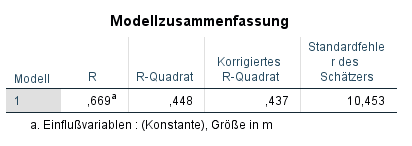

4.2 Güte des Regressionsmodells

Die Güte der gerechneten Regression wird anhand des Bestimmtheitsmaßes R-Quadrat (R²) abgelesen. Das R² ist zwischen 0 und 1 definiert. Es gibt an, wie viel Prozent der Varianz der abhängigen Variable erklärt werden. Ein höherer Wert ist hierbei besser. Bei einem R² von z.B. 0.65 werden 65% der Varianz der y-Variable erklärt. Im Beispiel erklärt das Modell 44,8% der Varianz, da das R² = 0.448 ist.

Pauschal gibt es in der linearen Regression keine Werte, ab denen man von einem “guten Modell” spricht. Vielmehr ist dies je nach Fachdisziplin unterschiedlich.

Höher ist zwar pauschal besser, je mehr potenzielle Einflussfaktoren aber existieren, desto weniger kann eine Variable allein erklären. Das Gewicht kann – abstrahiert von diesem fiktiven Datensatz – eben nicht nur durch die Körpergröße erklärt werden. Weitere Faktoren wie Ernährungsweise, Alter etc. sind denkbar.

4.3 Interpretation des Regressionskoeffizienten

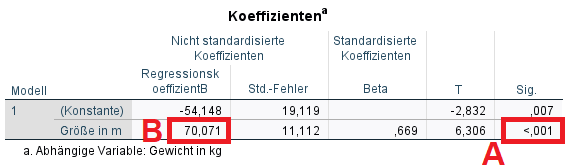

A)

In der einfachen linearen Regression ist der p-Wert des Regressionskoeffizienten mit dem p-Wert des F-Tests stets identisch. Wenn der F-Test “bestanden ist”, ist der Regressionskoeffizient somit auch signifikant (hier: p < 0.001).

Ist der Regressionskoeffizient signifikant, kann man die Nullhypothese für den Koeffizienten verwerfen. Diese geht von keinem Effekt der x auf die y-Variable aus. Die Verwerfung der Nullhypothese bekräftigt demnach die Unterstellung eines Effektes von Größe auf Gewicht.

B)

Unter “Nicht standardisierte Koeffizienten” ist der Regressionskoeffizient B zu sehen. Hier ist zunächst nur B für die x-Variable interessant.

Im Beispiel ist der Koeffizient der Größe 70.071.

Eine zusätzliche Einheit der “Größe in m” führt demnach zu einem zusätzlichen Gewicht in kg von 70.071 führt.

Wäre B fiktiv –70.071, würde eine Zunahme der Einheit “Größe in m” zu einer Abnahme des Gewichts von 70.071 führen.

Das Schema der Interpretation von B ist immer identisch: Steigere ich x um 1 Einheit, verändert sich y um B-Einheiten.

Die standardisierten Koeffizienten sind typischerweise nur im Falle einer multiplen linearen Regression zu interpretieren. Sie vergleichen die Stärken der Effekte der x-Variablen; allerdings nicht für kategoriale Variablen.

Ein letzter technischer Hinweis:

Teilt man B durch den Standardfehler (Std.-Fehler), erhält man den T-Wert (70.071/11.112 = 6.306).

Aus dem T-Wert wird letztlich der p-Wert ermittelt. Man kann sich merken, dass t-Werte >3 einen p-Wert < 0,05 zur Folge haben.

5 Prognose mittels Regressionsgleichung

Anhand der ersten Spalte der Koeffiziententabelle kann eine Regressionsgleichung aufgestellt werden. Hierfür wird B der Konstante und das Produkt aus x-Variable und B addiert:

![]()

Im Beispiel lautet sie:

![]()

Bei einer Prognose kann man nun einen beliebigen Wert für die Körpergröße einsetzen.

Setzt man z.B. 1.75m als Größe in diese Gleichung ein, erhält man auf Basis des Modells ein geschätztes Gewicht von 68.48 kg:

![]()

Hinweis: Solche Prognosen sind in ihrer Aussagekraft auf die zugrundeliegende Stichprobe eingeschränkt! Je besser die Stichprobe die Grundgesamtheit repräsentiert, desto eher kann für eine allgemeingültige Prognosekraft durch das geschätzte Modell argumentiert werden.

6 Reporting

In der einfachen linearen Regression gibt es eigentlich keine Notwendigkeit eine Tabelle zu erstellen. Man berichtet den Regressionskoeffizienten und die Signifikanz der unabhängigen Variable sowie die Modellgüte, also Bestimmtheitsmaß R² und F-Test (siehe oben).

Alternativ kannst du dir auch eine Tabelle mit meiner Vorlage generieren, die alle wesentlichen Daten enthät und zugleich nicht das Standardformat von SPSS-Tabellen hat.

7 Datensatz zum Download

8 Videotutorial

9 Literatur

- Field, A. (2018), Discovering Statistics Using IBM SPSS Statistics, SAGE, Kapitel 9

- Warner, R. M. (2013), Applied Statistics, SAGE, S. 344-383