Inhaltsverzeichnis

1 Sinn und Zweck von Fleiss’ Kappa

Zur kurzen Einordnung: Fleiss’ Kappa berechnet die Interrater-Reliabilität zwischen mehr als zwei Personen (=Ratern). Damit dient es der Beurteilung von Übereinstimmung zwischen mindestens drei unabhängigen Ratern. Außerdem ist mit Kappa ersichtlich, wie sehr die Rater in ihren Urteilen übereinstimmen. Ein typisches Beispiel ist, ob drei Psychologen oder Ärzte bei ihren Diagnosen übereinstimmen und Patienten dieselben Krankheiten diagnostizieren oder eben nicht. Wenn es sich um nur zwei Rater handelt, ist Cohens Kappa zu berechnen.

2 Voraussetzungen zur Berechnung von Fleiss’ Kappa in SPSS

Für die Berechnung bedarf es lediglich einer nominalen Skalierung der zu prüfenden Variable. Die Einschätzungen der verschiedenen (hier genau drei) Rater sollten in verschiedenen Variablen, also spaltenweise vorliegen. In etwa so, wie in folgender Übersicht. Hierbei bedeutet eine 0, dass die Rater keine Krankheit diagnostizierten. Eine 1 ist dementsprechend eine diagnostizierte Krankheit. Der vollständige Datensatz ist unten verlinkt. Wie Daten eingelesen werden, zeigt dieser Artikel.

Rater1 Rater2 Rater3

0 0 0

0 0 1

0 1 1

1 1 1

1 1 1

0 0 0

0 0 0

1 1 1

1 1 1

0 1 0

0 1 1

1 1 1

1 1 0

... ... ...

3 Vorbereitungen für Fleiss’ Kappa in R

Die Berechnung von Fleiss’ Kappa in R benötigt ein zusätzliches Paket names “DescTools“. Über install.packages(“DescTools“) und library(DescTools) wird es installiert und geladen:

install.packages("DescTools")

library(DescTools)

Im nächsten Schritt sollte man, sofern noch weitere Variablen im Datensatz existieren, diese eliminieren bzw. ein neues Subset bilden, das in die Funktion zur Berechnung von Fleiss’ Kappa übergeben wird. Dies ist notwendig, da die nachfolgend verwendete Version einen Vektor benötigt, der nur die Raterurteile beinhaltet. Das Subset wird über den Befehl subset gezogen. Ich selektiere aus dem Dataframe data_rater die Urteile der Rater, die jeweils in den Variablen Rater1, Rater2 und Rater3 hinterlegt sind, mit folgendem Befehl und speichere sie in einem Vektor namens “ratertab“.

ratertab <- subset(data_rater, select = c(Rater1, Rater2, Rater3))

4 Berechnen von Fleiss' Kappa in R und Interpretation der Ergebnisse

Die Funktion KappaM() aus dem bereits installierten Paket "DescTools" wird nun verwendet. Hierzu wird der eben erstellte Vektor "ratertab" übergeben sowie das entsprechende Kappa (methode="Fleiss") und wahlweise ein 95%-Konfidenzintervall (conf.level = 0.95) angefordert.

KappaM(ratertab, method = "Fleiss", conf.level = 0.95)

Nach der Ausführung erhält man folgende Ergebniszeile:

kappa lwr.ci upr.ci

0.6360656 0.4500340 0.8220971

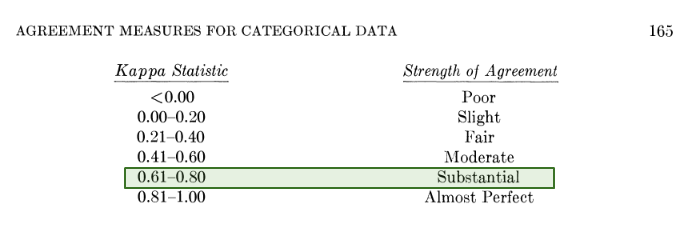

Fleiss' Kappa beträgt in meinem Beispiel 0,636. Schließlich stellt sich die Frage, wie hoch die Übereinstimmung ist. Sie kann theoretisch zwischen perfekt (1) und schlecht (0) sein. Im Beispiel ist die Übereinstimmung beachtlich ("substantial"). Hierzu dient folgende Systematisierung nach Landis und Koch (1977).

5 Literatur

Landis, J., & Koch, G. (1977). The Measurement of Observer Agreement for Categorical Data. Biometrics, 33(1), 159-174. doi:10.2307/2529310

6 Datensatz zum Download

Weitere nützliche Tutorials findest du auf meinem YouTube-Kanal.

7 Videotutorial